Les notions hors programme sont à travailler en priorité par les candidats visant les trois Parisiennes. Cet article te propose de découvrir la notion de racine carrée de matrice, thème assez récurrent dans les sujets de concours, pour mieux t’aider à la comprendre si tu te trouves face à ce sujet un jour de concours. Il te permettra aussi d’avoir en tête une preuve de l’existence et l’unicité de la racine carrée dans le cas d’une matrice symétrique positive.

Introduction aux racines carrées de matrices

Les puissances d’une matrice \(M\in M_n(\mathbb R)\) sont définies par récurrence : on définit \(M^0=I_n\) et pour tout \(p\in\mathbb N\), \(M^{p+1} = M^pM\).

Par extension, dans le cas où \(M\) est inversible, on peut même définir les puissances négatives. En effet, on a alors \((M^p)^{-1} = (M^{-1})^p\) pour tout \(p\in\mathbb N\). On peut alors définir sans ambiguïté la matrice \(M^{-p}\), qui désigne à la fois l’inverse de \(M^p\) et la matrice \(M^{-1}\) élevée à la puissance \(p\).

Avec ces définitions, rien ne définit a priori le concept de racine carrée de matrice, ou de puissance \(\frac12\) pour les matrices, puisque les définitions précédentes ne sont valables que pour des puissances entières.

De la même façon qu’on définit les puissances rationnelles pour les réels, on appelle racine carrée de \(M\) toute matrice \(B\in M_n(\mathbb R)\) telle que \(B^2=M\).

⚠️ Attention. La grosse différence avec la définition de racine carrée d’un réel (positif) est que chez les matrices, l’existence n’est absolument pas garantie… et encore moins l’unicité !

Il faut donc prendre des précautions. Lorsqu’elle existe, on dira d’une matrice \(B\) vérifiant \(B^2=M\) que c’est une racine carrée de \(M\), et non pas la racine carrée.

On ne pourra utiliser l’article « la » que dans des cas très particuliers où la matrice \(B\) est unique… dont on détaille des exemples dans la suite !

Premiers exemples

La matrice nulle

Tout d’abord, remarquons que la matrice nulle est une racine carrée de la matrice nulle.

D’autre part, posons, pour tout réel \(x\),

\[B_x = \begin{pmatrix} 0 & \cdots & 0 & x \\ \vdots & & & 0 \\ \vdots & & & \vdots \\ 0 & \cdots & \cdots & 0 \end{pmatrix}\]

Alors, pour tout réel \(x\), on a également \(B_x^2 = 0\), donc \(B_x\) est une autre racine carrée de la matrice nulle.

Donc la matrice nulle admet une infinité de racines carrées.

La matrice identité

Nous allons montrer que la matrice \(I_2\) admet une infinité de racines carrées.

On pose, pour tout réel \(t\),

\[R_t = \begin{pmatrix} \cos t & \sin t \\ \sin t & -\cos t \end{pmatrix}\]

Montrons que \(R_t^2 = I_2\). On a

\[R_t^2 = \begin{pmatrix} \cos^2t+\sin^2t & 0 \\ 0 & \cos^2t+\sin^2t \end{pmatrix} = I_2\]

On vient donc de montrer que pour tout \(t\in\mathbb R\), \(R_t\) est une racine carrée de \(I_2\).

Or, par exemple, si \(t\) et \(t’\) sont deux réels distincts de \([0,\pi]\), alors on a \(\cos t \ne \cos(t’)\), donc \(R_t \ne R_{t’}\).

Ainsi, les matrices \(R_t\) pour \(t\in [0,\pi]\) sont deux à deux distinctes.

Comme \([0,\pi]\) contient une infinité de réels, \(I_2\) admet une infinité de racines carrées.

Une matrice qui n’admet pas de racine carrée

Nous allons montrer par l’absurde que la matrice \(M = \begin{pmatrix} 0 & 1 \\ 0 & 0 \end{pmatrix}\) n’admet pas de racine carrée.

Supposons qu’il existe une matrice \(B = \begin{pmatrix} a & b \\ c & d \end{pmatrix}\) telle que \(B^2=M\). On a donc :

\[\begin{pmatrix} a^2+bc & b(a+d) \\ c(a+d) & d^2+bc \end{pmatrix} = \begin{pmatrix} 0 & 1 \\ 0 & 0 \end{pmatrix}\]

Par conséquent, \(b(a+d)=1\ne 0\), d’où \(a+d\ne 0\).

On a aussi \(c(a+d)=0\), d’où \(c=0\).

On en déduit que \(a^2=d^2=0\), i.e, \(a=d=0\). Ceci contredit \(a+d\ne 0\).

Ainsi, \(\begin{pmatrix} 0 & 1 \\ 0 & 0 \end{pmatrix}\) n’admet pas de racine carrée.

Une matrice diagonale

Pour simplifier les notations, pour tous \(\lambda_1,\dots,\lambda_n\in\mathbb R\), on note \(\text{diag}(\lambda_1,\dots,\lambda_n)\) la matrice diagonale de \(M_n(\mathbb R)\) dont les coefficients diagonaux sont \(\lambda_1,\dots,\lambda_n\) :

\[\text{diag}(\lambda_1,\dots,\lambda_n) = \begin{pmatrix} \lambda_1 & & (0) \\ & \ddots & \\ (0) & & \lambda_n \end{pmatrix}\]

Considérons par exemple la matrice \(M = \text{diag}(1,4,9)\).

Notons \((X_1,X_2,X_3)\) la base canonique de \(M_{3,1}(\mathbb R)\). On remarquera qu’il s’agit d’une base de vecteurs propres de \(M\), le vecteur \(X_i\) étant associé à la valeur propre \(i^2\) pour tout \(i\in\{1,2,3\}\).

Déterminons, par analyse-synthèse, toutes les racines carrées de \(M\).

Analyse. Soit \(B\in M_3(\mathbb R)\) telle que \(B^2=M\).

On a pour tout \(i\in\{1,2,3\}\),

\[MBX_i = B^3X_i = BMX_i = B(i^2X_i) = i^2BX_i\]

Donc \(BX_i\in\ker(M- i^2X_i)\).

Or, \(M\) admet 3 valeurs propres distinctes, donc \(\dim(\ker(M- i^2X_i))=1\).

Il existe donc un réel \(\alpha_i\) tel que \(BX_i=\alpha_i X_i\).

\(B\) est donc diagonalisable dans la base canonique : \(B = \text{diag}(\alpha_1,\alpha_2,\alpha_3)\).

Puisque \(B^2=M\), on a :

\[\left\{\begin{array}{l} \alpha_1^2 = 1 \\ \alpha_2^2 = 4 \\ \alpha_3^2 = 9 \end{array}\right. \iff \left\{\begin{array}{l} \alpha_1 = \pm 1 \\ \alpha_2 = \pm 2 \\ \alpha_3 = \pm 3 \end{array}\right.\]

Synthèse. Réciproquement, il est clair que toute matrice de la forme \(\text{diag}(\alpha_1,\alpha_2,\alpha_3)\) avec \(\alpha_1 = \pm 1\), \(\alpha_2 = \pm 2\), \(\alpha_3 = \pm 3\) est une racine carrée de \(M\).

Remarque : on a ainsi prouvé que \(M\) admet exactement 8 racines carrées.

On peut démontrer plus généralement, par un raisonnement similaire, que si \(M\in M_n(\mathbb R)\) est diagonalisable et admet \(n\) valeurs propres distinctes strictement positives, alors \(M\) admet exactement \(2^n\) racines carrées.

Cas d’une matrice symétrique positive

Soit \(S\in M_n(\mathbb R)\) une matrice symétrique.

Définition (hors-programe, mais pratique dans ce contexte et très classique) : On dit que \(S\) est symétrique positive lorsque pour tout vecteur \(X\in M_{n,1}(\mathbb R)\), \({}^tXSX\geq 0\).

On note \(S_n^+(\mathbb R)\) l’ensemble des matrices symétriques positives.

Il y a une propriété hyper importante sur ces matrices :

\(S\) est symétrique positive si et seulement si toutes les valeurs propres de \(S\) sont positives.

La preuve est dans cet article. Elle est archi-classique et je t’encourage à la lire, la comprendre, l’apprendre par cœur et la relire tous les soirs avant de t’endormir.

Dans toute la suite de cet article, on suppose que \(S\) est symétrique positive.

Existence d’une racine carrée

Puisque \(S\) est symétrique réelle, il existe \(P\in M_n(\mathbb R)\) orthogonale et \(\lambda_1,\dots,\lambda_n\in\mathbb R_+\) tels que \(S = P\text{diag}(\lambda_1,\dots,\lambda_n){}^tP\).

On pose \(B = P\text{diag}(\sqrt{\lambda_1},…,\sqrt{\lambda_n}){}^tP\).

Alors \(B^2=P(\text{diag}(\sqrt{\lambda_1},…,\sqrt{\lambda_n}))^2{}^tP=S\).

On peut remarquer que cette matrice \(B\) est symétrique positive. On a donc montré un résultat plus fort : \(S\) admet toujours une racine carrée symétrique positive.

Unicité de la racine carrée symétrique positive

Nous allons démontrer le résultat suivant : \(S\) admet une unique racine carrée symétrique positive.

Autrement dit, il existe une unique matrice \(B\in S_n^+(\mathbb R)\) telle que \(B^2=S\).

Soient \(B_1,B_2\in S_n^+(\mathbb R)\) deux matrices telles que \(B_1^2=S\) et \(B_2^2=S\). Montrons que \(B_1=B_2\).

Puisque \(B_1\) et \(B_2\) sont symétriques positives, il existe deux matrices orthogonales \(P_1\) et \(P_2\) et des réels positifs \(\alpha_1,\dots,\alpha_n,\beta_1,\dots,\beta_n\), tels que

\[B_1=P_1\text{diag}(\alpha_1,\dots,\alpha_n){}^tP_1 \quad \text{ et } \quad B_2=P_2\text{diag}(\beta_1,\dots,\beta_n){}^tP_2\]

Par hypothèse, on a \(B_1^2=B_2^2\), c’est-à-dire

\[P_1\text{diag}(\alpha_1^2,\dots,\alpha_n^2){}^tP_1 = P_2\text{diag}(\beta_1^2,\dots,\beta_n^2){}^tP_2\]

Posons \(P={}^tP_1P_2\). En multipliant à gauche par \({}^tP_1\) et à droite par \(P_2\) dans l’égalité précédente, en utilisant le fait que ces matrices sont orthogonales, on obtient

\[\text{diag}(\alpha_1^2,\dots,\alpha_n^2)P = P\text{diag}(\beta_1^2,\dots,\beta_n^2)\]

Ces matrices coïncident donc coefficient par coefficient, ce qui revient à dire que

\[\forall (i,j)\in[\![ 1,n ]\!], \quad \alpha_i^2 P_{i,j} = \beta_j^2 P_{i,j}\]

Si \(P_{i,j} \ne 0\) alors en divisant par \(P_{i,j}\) on obtient \(\alpha_i^2 = \beta_j^2\) ; or \(\alpha_i\) et \(\beta_j\) sont positifs car \(B_1\) et \(B_2\) sont à valeurs propres positives, d’où \(\alpha_i=\beta_j\) et donc \(\alpha_i P_{i,j} = \beta_j P_{i,j}\). Cette égalité reste évidemment vraie si \(P_{i,j}=0\). Donc

\[\forall (i,j)\in[\![ 1,n ]\!], \quad \alpha_i P_{i,j} = \beta_j P_{i,j}\]

Maintenant, il s’agit de revenir en arrière pour arriver au fait que \(B_1=B_2\).

On en déduit que

\[\text{diag}(\alpha_1,\dots,\alpha_n)P = P\text{diag}(\beta_1,\dots,\beta_n)\]

En multipliant à droite par \({}^tP_2\) et à gauche par \(P_1\) on en déduit que \(B_1=B_2\).

Par conséquent, la racine carrée symétrique positive de \(S\) est unique.

Remarque. Dans certains sujets de concours, tu croiseras sûrement des notations telles que \(S^{1/2}\) ou encore \(\sqrt{S}\), où \(S\) désigne une matrice symétrique positive. Ces notations ont un sens grâce au fait que la racine carrée symétrique positive de \(S\) existe et est unique.

Conclusion

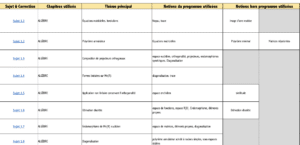

Ce concept de racine carrée de matrices est un grand classique des concours. Rien que cette année, ce thème est tombé à l’emlyon !

Pour t’entraîner et maîtriser parfaitement ce concept, je te conseille de faire les sujets suivants : emlyon 2009 et HEC 2019, ou plus récemment, emlyon 2024.

N’hésite pas à consulter toutes nos ressources mathématiques !